KI-Wochenpost 2024-25/26

Hallo,

auch in diesem Update kann Adobe nicht fehlen. Die Strategie, die sich zur Verärgerung der Kreativszene in den letzten Monaten ja schon angedeutet hat ("Skip the Photoshoot" und so), kristallisiert sich immer deutlicher heraus: Seine zukünftigen Geschäftsmodelle sieht der Konzern weniger bei den klassischen Bildautoren/Illustratoren/Designern sondern im Bereich der Corporate Publications. Sprich, man richtet sich in einer Welt ein, in der Content-Kunden denselben gleich selbst herstellen.

Schon letztes Jahr haben einzelne von uns (die hoffentlich demnächst an dieser Stelle auch mal aus erster Hand darüber berichten können), Software-Demos von Konsumartikel-Herstellern gesehen, deren KI-Modelle bereits mit den hauseigenen Produkten und Konzernimage-konformen Settings vortrainiert sind. Fortan können alle Beschäftigten die Bedarf an Bildmaterial haben, dieses mit wenigen Klicks auch eigenhändig erzeugen – sagen wir mal Küchengeräte, die von dunkelhäutigen Frauen in bunten Sommerkleidern bedient werden.

Das spart natürlich nicht nur Kosten, sondern auch nervige Besprechungen mit Artdirektoren, Briefings von FotorgrafInnen und GrafikerInnen etc. Neben den unmittelbaren wirtschaftlichen Auswirkungen auf jene, die bisher für das Erzeugen solcher Bilder Rechnungen gestellt haben, wird es sicher auch interessant sein, zu sehen, wie diejenigen innerhalb der Konzernhierarchien mit dem Bedeutungsverlust umgehen, die ihre Position bisher damit rechtfertigten, dass Sie das optische Gehirn solcher Marketing- und Werbeaktivitäten waren, das andere nur technisch umzusetzen hatten.

Hier bahnt sich auch ein technisches Wettrennen mit klassischen Werbeagenturen an, die sich ja schon länger in gute KI-Startpositionen zu bringen versuchen und ihren Kunden zielgenaueres Targeting, schnelleren Turnaround Urheberrechts-Sicherheit versprechen. Es könnte sein, dass das alles nichts nützt, und die Kunden das in Zukunft lieber gleich komplett selbst erledigen.

Wir haben von der Fotorat-Arbeitsgruppe vor zwei Wochen einen ersten virtuellen Workshop mit BildredakteurInnen zum Umgang mit KI-Bildgeneratoren veranstaltet (der auf großes Interesse stieß, und dem wir hoffentlich im Herbst ein öffentliches Nachfolgetreffen folgen lassen werden), in dem auch VertreterInnen des Corporate Publishings saßen. Ohne jetzt schon zu viel zu aus dem vertraulichen ersten Kennenlernen zu verraten: Auch dort bilden sich gewisse Risse zwischen Management-Ebenen, die ganz scharf darauf sind, synthetische Bilder möglichst flächendeckend einzusetzen und BildredakteurInnen, die sich als Spielverderber gebrandmarkt sehen, wenn sie fragen, warum man sich etwa mit Durchschnittsgeneraten von Tomaten zufrieden geben sollte, wenn man liebevoll fotografiertes Gemüse zuhauf in den Bilddatenbanken liegen hat.

Aber ich wollte ja eigentlich von Adobe sprechen. Dort werden jetzt offenbar verstärkt KI-Module schlichtweg überall eingebaut, wo es die Büro-Kundschaft brauchen könnte. Dafür gibt es "Adobe Express", eine Design-Suite die speziell auf die BewohnerInnen von Großraumbüros zugeschnitten ist, und es ermöglich "tausende von Inhalten in Minuten statt in Monaten bereitzustellen."

Hier gibt es ein Video von Adobe, das zum "Design made Easy"-Event Mitte Juni produziert wurde:

"Das neue Adobe Express wurde für Unternehmen entwickelt und macht es jedem in einem Unternehmen leicht, markengerechte visuelle Inhalte zu entwerfen, die die Geschäftsergebnisse fördern."

David Wadhwani, president Adobe Digital Media Business

Auf der Veranstaltung wurde auch eine Partnerschaft mit Microsoft bekanntgegeben: Eine Adobe-Express-Erweiterung für Microsoft Copilot beamt Adobes generierte Bilder direkt in die Büro-Software der Microsoft-365-Suite.

"Diese Zusammenarbeit wird es Unternehmen ermöglichen, nahtlos hochwertige, markengerechte Inhalte direkt in der Microsoft 365-Umgebung zu erstellen und so die Produktivität und Kreativität in verschiedenen Unternehmensanwendungen zu steigern."

Rob Howard, Vice President of Microsoft 365 developer platforms

So könne man in Zukunft gleich ganze Prompt-Batterien in Form von Exceltabelle zum Generator schicken und bekommt das Bildmaterial postwendend angeliefert.

Ganz folgerichtig kündigt Adobe an, die Bilderzeugungsfunktionen seiner "Firefly"-Modelle auch direkt in die Profi-Versionen seines pdf-Editors "Acrobat" zu implantieren (nicht zu verwechseln mit dem kostenlosen Acrobat Reader). Das Universaltool typischer Angestellter in jenen Bergwerken, in denen aus Geschäftszahlen und Verkaufsstatistiken bunte Berichte für diverse Exekutivebenen entstehen, kann künftig auch also auch vorhandene Bilder generativ erweitern und neu zuschneiden, ungewollte Objekte in diesen entfernen oder ersetzen, oder gleich ganz neue Bilderwelten in das Dokument hineinerfinden.

Die Kollegen von Docma haben das hier ein wenig erläutert.

Etwa gleichplatziert auf der Hitliste der Stirnrunzelerzeuger mit Adobe steht weiterhin OpenAI. Deren oberste Technologin Mira Murati hatte sich unlängst mächtig in die Nesseln gesetzt, als sie sich mit leicht entgleisten Gesichtszügen um eine Antwort auf die Frage drückte, ob sich die Firma zum Training des spektakulären Videogenerators Sora auch Youtube-Videos einverleibt habe.

Nun erschien sie zu einem längerem Gespräch an ihrer ehemaligen Uni Dartmouth Engineering und erläuterte mit nerdig gedrosselter Empathie ihre Einschätzung, wie die KI-Produkte wohl zukünftig das Geschäfts- und Erwerbsleben beeinflussen werden. Es ist ganz interessant sich das mal in längeren Passagen anzusehen, auch in den Reaktionen auf die Fragen der StudentInnen, in denen sie sich noch einmal erstaunt darüber zeigte, dass manche Zuhörende nach der Premiere von ChatGPT 4o den "subjektiven Eindruck" hatten, die KI-Stimme könnte von Scarlett Johansson abgekupfert worden sein. Beschränken wir uns darauf das in der Folge am berühmtesten gewordene Zitat der Veranstaltung aus dem Zusammenhang zu reißen:

"Einige kreative Arbeitsplätze werden vielleicht wegfallen, aber vielleicht hätten sie gar nicht erst entstehen sollen."

OpenAI CTO Mira Murati

Man könnte den Eindruck haben, dass die Erzeugung von fotorealistischen Bildern inzwischen schon fast langweilig wird und Verbesserungen an den Modellen nur noch routinierte Randnotizen wert sind. Bemerkenswert rasant verläuft dagegen die Frequenz der Veröffentlichung neuer Video-Generatoren. Gerade noch rieb sich die Welt staunend die Augen als OpenAI die Previews von Sora zeigte, und noch immer dreht das Modell Testrunden mit ausgewählten und speziell qualifizierten Usern, bevor es irgendwann – mutmaßlich noch dieses Jahr – auch Normalnutzenden zur Verfügung stehen wird, da gibt es schon mehrere Newcomer, die ganz ohne Wartezeiten ähnliche Ergebnisse der Text-to-Video-Konversion versprechen.

Da wären zu nennen:

Kling (derzeit nur für chinesische NutzerInnen)

Daneben gibt es diverse eingeschränkte Generatoren, die z.B. Avatare animieren oder Leute aus hochgeladenen Videoschnipseln clonen, um damit ContentcreatorInnen auch noch das lästige Posieren vor der Kamera abzunehmen.

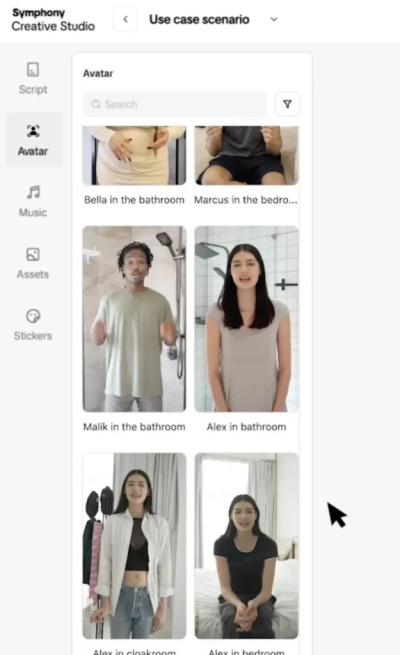

TikTok baut so eine Funktion direkt in seine App ein und stellt mit seinem "Symphony Creative Studio" täuschend echt wirkende Allerweltsmenschen in unglamourösen Umgebungen zur Verfügungen, denen man beliebige Botschaften in den virtuellen Mund legen kann.

TikTok preist das Tool vor allem für Werbetreibende an, die so ohne größeren Aufwand ihre Botschaften im Influencer-Look unter die Leute bringen können.

Hier die Pressemitteilung dazu.

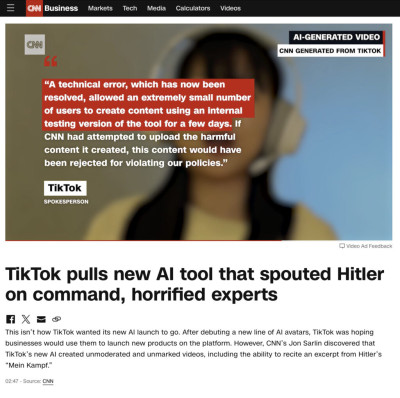

CNN gab sich besonders investigativ und fand geschockt heraus, dass man die Avatare auch Passagen aus Hitlers Hetzschrift "Mein Kampf" rezitieren lassen kann.

Ach gar...

TikTok begründete den Lapsus mit einem technischen Versehen, durch das eine eigentlich nur interne verwendete Testversion auch externen Nutzern zugänglich gemacht worden sei.

Nicht dass ich dafür wäre, der Jugend faschistoide Wahngedanken zu verkünden (das tun ja leider inzwischen schon ein paar gewählte Parlamentarier auch ohne KI). Aber ähnlich wie bei der amerikanischen Empörung darüber, dass jüngst eine Version des Google-Bildgerators im Bemühen die Vorgaben der Programmierer nach mehr Diversität und dem Vermeiden von Stereotypen über das Ziel hinausgeschossen war und Bilder von dunkelhäutigen Menschen in SS-Uniformen erzeugt hatte, wird sich auch hier bei aller Erregung der Traum von ethisch einwandfreien und politisch korrekten KI-Modellen nicht erfüllen lassen. Dafür müssten die Generatoren nun einmal tatsächlich irgend ein Verständnis davon haben, was sie inhaltlich von sich geben, und die Liste der verbotenen Begriffe müsste je nach Kontext und Adressat so granular feingliedrig ausbuchstabierbar sein, das zum Schluss auch politische/weltanschauliche Empfindlichkeiten berücksichtigt werden, etwa bei der Frage, welchen staatlichen Status Taiwan hat, oder wo das Volk der Kurden beheimatet ist. Statt bei jeder aufgedeckten Entgleisung der Generatoren zu versuchen, die Zensurregeln nachzubessern, wird es Zeit, sich über das Umfeld von deren Einsatz Gedanken zu machen.

Die Washington Post fand derweil heraus, dass viele aktuellen Sprachmodelle nicht in der Lage sind, eindeutig auf die Frage zu antworten, wer die US-Präsidentenwahl des Jahres 2020 gewonnen hat. Amazons Alexa habe Donald Trump für wahrscheinlich gehalten. Googles Gemini gab zurück "Ich lerne noch diese Frage zu beantworten", und Microsofts Copilot erklärte "Scheint so, als könne ich zu diesem Thema nichts sagen."

Auch der Spiegel hat ähnliche Experimente im Vorfeld der Europawahl gemacht und traf ebenfalls auf ein Gemisch von halbgaren Quasi-Informationen und vorsorglichen Auskunftblockaden.

Die Versuche von Instagramm, KI-generierte Bilder automatisch als solche kenntlich zu machen, müssen wohl einstweilen als gescheitert gelten. Immer öfter haben sich in den letzten Wochen seit der Einführung des Features NutzerInnen darüber beklagt, dass gänzlich unmanipulierte Fotos mit dem "Made with KI"-Logo verunglimpft wurden. Petapixel hat hier zusammengetragen, welche Werkzeuge der Bildbearbeitung vermutlich zu dieser Einstufung führen können.

So triggert wohl das Enfernen von Sensordreck mittels generativem Fill die Warnung, auch wenn der simple Pixel-Stempel im Ergebnis nichts anderes macht. Das mag vom Prinzip her konsequent sein, doch scheint das Entfernen kompletter Bildelemente in Lightroom kein KI-Kainsmal hervorzurufen. Der Pressefotograf Pete Souza fand hingegen das KI-Label auf einem Scan seines 40 Jahre alten Schwarzweißfotos eines Basketballspiels.

Meta, die Mutter von Instagram und Facebook hat nun erstmals Stellung zu den Problemen bezogen und verspricht, den Ansatz zu "überdenken".

Bis demnächst

Jürgen