KI-Wochenpost 2024-32/35

KI-Firmen machen keinen Sommerurlaub. Das können sie sich nicht leisten, denn die Investoren wollen für die Milliarden, die verbrannt werden, regelmäßig frische Resultate sehen. Das infiziert auch die kleineren Player, denn in der Branche hängt alles mit allem zusammen, und wenn OpenAI Erwartungsstress wegen mutmaßlich abflachender Fortschrittskurven bekommt, müssen andere zeigen, dass sie entweder die Chance nutzen um aufzuschließen oder dass ihre Kurve noch schön steil nach oben zeigt.

So sind auch im Bereich der Bildgeneratoren in den letzten Wochen wieder zahlreiche Neuheiten verkündet worden, oder zumindest Dinge, die sich als solche vermelden lassen.

Midjourney hatte Ende Juli mit Version 6.1 zunächst viele Details verbessert. So sollen jetzt Bilddetails und Texturen präziser dargestellt sowie die "Kohärenz" in den Bildern verbessert werden, also Ausreißer und Artefakte reduziert sein.

Im August wurde dann endlich allgemein zugänglich, was schon erstaunlich lange in elitären Alpha-Testerkreisen vor sich hin gegärt hatte: Ein Web-basiertes Interface, mit dem man ähnlich wie bei den meisten anderen Bildgeneratoren Prompts nicht mehr nur ähnlich archaischer Programmiersprachen per Befehlszeile im Discord-Chat übermitteln kann, sondern in Textboxen eingibt, in deren Nähe man auch die Ergebnisse zu sehen bekommt, sowie an Reglern und Knöpfen drehen kann.

Wer durch die opulenten Musterbild-Galerien anderer User streift und Lust verspürt, sich selbst an dem von vielen Kennern als nach wie vor bester Generator eingeschätzten System zu versuchen, wird sogleich zum Abschluss eines Abos ab $10 pro Monat genötigt. Mal sehen, ob diese Marketing-Offensive den erhofften umsatzsteigernden Effekt hat.

Noch nicht ganz so gut zugänglich ist der Generator der Newcomer von Black Forest Labs. Deren Bild-KI "Flux.1" verspricht vor allem das Ende von Artefakten wie missgebildeten Händen in KI-Bildern.

Das könnte man als übliches Marketing-Geräusch werten, doch die Gründer der in den USA ansässigen Firma, Robin Rombach, Andreas Blattmann und Dominik Lorenz gehören zu den Wissenschaftlern der ersten Stunde, die einst in universitären Forschungsgruppen in München und Heidelberg die Bilderzeugung auf Basis von Diffusionsmodellen erfanden. Vor Gründung ihrer eigenen Firma waren sie bei Stability.ai tätig, das in der kommerziellen Anwendung der Modelle Vorreiter war, aber lange Mühe hatte, die typischen Bildfehler wie sechsfingrige Hände in den Griff zu bekommen. Mit einem öffentlich kommunizierten Investment von 31 Millionen Dollar spielt das Startup Etat-mäßig noch in der Sandkiste, aber die Erwartungen sind groß. Schon bald will die Firma auch einen Diffusionsmodell-basierten Video-Generator vorstellen und damit gegen OpenAIs Schlagzeilen-Giganten "Sora" antreten.

Das Arbeiten mit dem Flux-Generator erfordert derzeit noch ein paar nerdige Umwege, wie den Zugriff auf andere KI-Modell-Hostingservices. Die Kollegen von Ars Technica haben das Modell ausgiebig getestet und bescheinigen ihm Qualitäten, die mit Platzhirschen wie Dall-E und Midjourney mithalten können. Bei der Herkunft der Trainingsdaten bleiben die Informationen jedoch derzeit dunkel wie der namensgebende Schwarzwald. Ars Technica mutmaßt, hier könnte die berüchtigte LAION-Datenbank verwendet worden sein, auf die wir ja insbesondere aus Anlass des in Hamburg geführten Gerichtsverfahrens ein kritisches Auge geworfen haben.

Mit demselben Prompt wie beim Dall-E Titelbild dieses Posts liefert Flux zumindest eine interessante Variation des Themas:

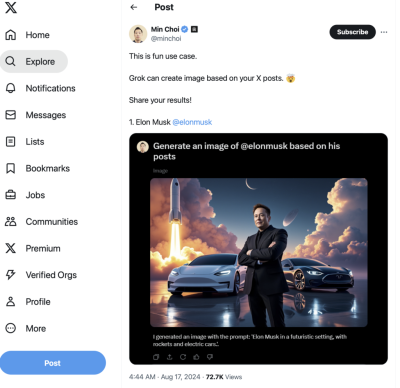

Blitzschnell hat sich Elon Musks Spielwiese X das Flux-Modell geangelt, um damit seinen Plattform-integrierten Bildgenerator Grok anzutreiben. Gemäß seines libertinären Credos, auf X die unzensierte Debatte zu pflegen, scheint auch der Grok-Generator wenig interne Bremsen eingebaut zu haben, mit denen andere KI-Werkzeuge inzwischen beispielsweise Abbildungen von Prominenten unterbinden, Darstellungen von Waffen oder unzüchtig unverhüllte Körperteile.

Fröhlich getestet haben dies natürlich gleich zahlreiche X-User und bereichern die Welt mit synthetischen Posts von Lady Gaga, Justin Bieber oder eben dem King of X:

Im Blog von Docma gibt es eine schöne Sammlung jener kaum beschränkten Bilder. Inklusive solcher, die sich um typische amerikanische Prüderiefilter herummogeln, die zwar wuchtige Schnellfeuerwaffen lustvoll ausziselieren aber bei Reizwörtern wie "Bikini" Alarm schlagen. Dass solche Ansätze schon konzeptionell problematisch sind, hat Docma-Urgestein Doc Baumann ja schon in verschiedenen Beiträgen angeprangert, als er sich beispielsweise genötigt sah, auf einen für Pornografie optimierten Bildgenerator zurückzugreifen (ja, auch das gibt es natürlich im Netz zu abonnieren), um Bilder von pseudo-antiken Statuen herzustellen, die artgerecht eher wenig anhaben.

Natürlich ist es verwerflich und illegal, reale Personen ohne ihr Wissen und ihre Zustimmung mit KI-gefakten Sexbildern zu demütigen, nur werden die potentiellen Straftäter das mit geeigneten Werkzeugen mit hoher Wahrscheinlichkeit trotzdem tun, während alle anderen Bildschaffenden sich ständig vor der roten Karte fürchten müssen, wenn ein Prompt auf der geheimen schwarzen Liste steht oder irgendein Algorithmus einen zu hohen Prozentsatz hautfarbener Pixel diagnostiziert.

Das Heldenbildchen von Musk aus dem X-Generator ist insofern symptomatisch/ironisch, als Musk besonders bei Betrügern als Rohmaterial beliebt ist, die mit angeblichen Investment Tipps des Elektroauto/Raketen-Visionärs Geld bei leichtgläubigen Kleinanlegern abgreifen.

Dieser Artikel der New York Times schildert ausführlich, wie raffinierte Trickdiebe durch Umarbeitung von authentischem Videomaterial Promotionbotschaften von mutmaßlichen Finanzgenies wie Musk, Bezos oder Warren Buffet generieren. Viele der Videos erwecken dabei den Eindruck, Youtube Live-Mitschnitte von angeblichen Großveranstaltungen zu sein, auf denen ein oppulentes Publikum die fiktiven Ankündigungen bejubelt. Daten von Sensity (eine Firma, die damit natürlich auch ihr Tool zum Erkennen von KI-Fakes promoted), legen nahe, dass Musk in einem Viertel der untersuchten Fakes seinen Auftritt hatte und Hauptdarsteller in vollen 90% der Betrugsvideos zum Reichwerden mit Kryptowährungen war.

Die Unternehmensberater von Deloitte schätzen, dass sich das Volumen betrügerischer Finanztransaktionen von derzeit über 10 Milliarden Dollar jährlich durch den Einsatz von KI-Werkzeugen bis 2027 verdoppeln könnte.

Ein ungutes Gefühl hinterlässt vor diesem Hintergrund eine Software wie "Deep Live Cam", über die hier Ars Technica berichtet. Dieser KI-Generator benötigt nur ein normales Portraitfoto einer beliebigen Person, um selbige als Fake-Gesicht dann im Livestream einer Webcam anstelle der Real-Physiognomie des Menschen vor der Kamera einzublenden. Im Beispiel grimmassiert der Demonstrator recht überzeugend wahlweise als Meta-Chef Zuckerberg, US-republikanischer Vizepräsidenten-Kandidat Vance oder Filmstar George Clooney.

Dass die Erosion der Wirklichkeit sowohl von Bildfälschungen angetrieben wird, wie auch von deren bloßer Behauptung und dem damit einhergehenden generellen Misstrauen in Fotos, demonstriert wieder einmal Donald Trump.

Einerseits teilt der wenig Wahrheitsaffine gerne KI-generierte Bilder von angeblichen Swift-Fans des Präsidenten-Kandidaten (die von seinem X-Account wieder verschwunden sind, aber in Erinnerungs-Enthüllungsposts anderer User weiterleben)

Andererseits wiegelt Trump seine Anhänger gegen Konkurrentin Kamala Harris auf, indem er behauptet, Fotos, die sie mit großen Menschenmengen zeigen, seien per KI gefälscht, denn in Wirklichkeit sei "NIEMAND" da gewesen:

Dabei ficht es den Demagogen auch nicht an, dass es mehrstündige Liveübertragungen der angezweifelten Veranstaltung im Fernsehen zu sehen gab und die Fotos in allen namhaften Medien zu sehen sind.

Gerne teilt Trump auch TikTok-kompatible Video-Generate, die ihn scheinbar mit (schon wieder) Musk zeigen

Bei diesen Beiträgen ist schwer auszumachen, ob die tatsächlich irgendwer für echte Aufnahmen hält, oder ob solche kommentarlos veröffentlichten Posts nicht genau den Zweck haben, eine Art Grundrauschen von medialem Dauerirrsinn zu erzeugen, vor dem sich jederzeit nach Bedarf retrospektiv dieses oder jenes als "satirisch gemeint" erklären lässt.

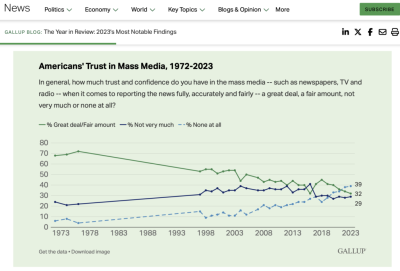

Das muntere Spiel mit dem "Die einen sagen so, die anderen so" dürfte den Trend zum allgemeinen Misstrauen in Bilder jeglicher Art weiter befeuern. So stellte das Meinungsforschungsinstitut Gallup schon Ende letzten Jahres fest, dass nunmehr der Punkt erreicht sei, an dem jene Amerikaner die größte Gruppe bilden, die Medien "überhaupt kein" Vertrauen (39%) entgegenbringen im Vergleich zu "ziemlich viel" (32%) oder "nicht sehr viel" (29%).

Einen ähnlichen Stossseufzer ("Manche Leute glauben uns einfach prinzipiell gar nichts mehr") hörten wir kürzlich auch in einem Workshop der Fotorats-Arbeitsgruppe mit BildredakteurInnen. Mehr dazu in Kürze.

Bis demnächst

Jürgen